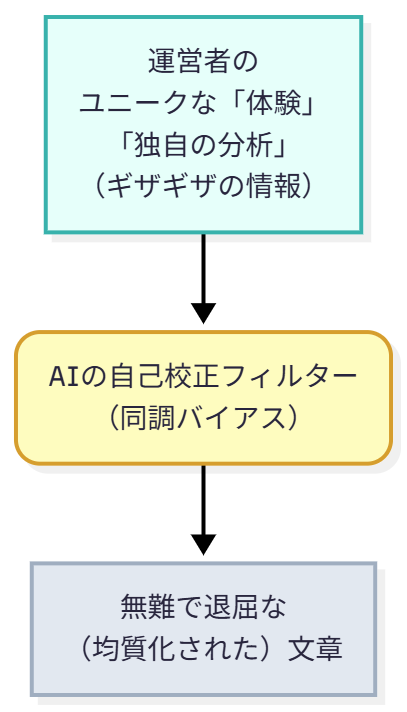

導入:AI校正の罠。「面白い」記事はAIの自己添削では生まれない

「AIが書いた記事、どうも『面白く』ない…」

AIブログ運営に本気で取り組むあなたなら、一度はこう感じたことがあるのではないでしょうか?

文法は完璧。誤字もない。ロジックも一応通っている。しかし、読者の心を動かす「熱」や「説得力」、書き手の「個性」が決定的に欠けている。

焦ったあなたは、AIにこう指示します。

「この記事を校正して、もっと魅力的にしてください」

しかし、返ってくるのは表面的な「てにをは」の修正や、わずかな言い回しの変更だけ。記事の根本的な「退屈さ」は解消されないまま、結局、あなたが深夜までモニターに向かい、大幅に手直しすることになる…。

この「AIによるAIの自己添削」こそが、AIブログ運営者が陥る最大の「罠」です。

私自身、この罠に深くハマっていました。「AI記事の品質革命。検査プロンプト術」を駆使してAIにチェックさせても、なぜか品質が上がらない。「AIは所詮、この程度か」と諦めかけ、AIが生成した記事の9割を自分で書き直していた時期もあります。

なぜAIは「自分の記事」を面白くできないのか?

結論から言えば、AIには「自己修正ブラインドスポット(Self-Correction Blind Spot)」があるからです。

驚くべきことに、ある研究によれば、大規模言語モデル(LLM)は、外部(人間など)から与えられた情報に含まれるエラーは的確に修正できるのに、「自分自身」が出力したエラー(同じ内容)に対しては、修正に失敗する確率が平均で64.5%にも上るという報告があります。

これは、AIが知識不足だからではありません。AIは「自分の推論」を正しいと見なしがちで、それを客観的に疑うことが極端に苦手なのです。

これをブログ運営に当てはめてみましょう。

- AI(著者):「この構成が論理的で最適だ」と判断して記事を生成する。

- あなた:「この記事を校正して」と指示する。

- AI(校正者):「(自分自身が最適だと判断した構成なので)構成は論理的で最適です。誤字を3箇所修正しました」と回答する。

これが、「文法は直るが、面白くはならない」の正体です。

AIは、人間が持つような「確証バイアス(自分の考えを肯定する情報ばかり集める傾向)」すら模倣するため、単一のAIに「検査」をさせても、根本的な構成の欠陥や、読者に刺さらないロジックの飛躍を見抜くことはできません。

E-E-A-Tを損なう「AIの同調」

この「AIの自己肯定」は、Googleが重視するE-E-A-T(経験・専門性・権威性・信頼性)の観点からも致命的です。

この「自己修正ブラインドスポット」こそが、AIがAIに『同調』してしまう根本原因です。その結果、AIは自らの生成した「体験(Experience)」の欠如や「独自性」のなさを修正できず、以下のようなE-E-A-Tを欠いた均質的なコンテンツが生まれてしまうのです。

- 「経験 (Experience)」の欠如:AIは実体験を持たないため、当たり障りのない一般論しか書けません。それをAIが校正しても、「体験談」が追記されることはありません。

- 「専門性 (Expertise)」の欠如:誰が読んでも同じ感想を持つような、個性のない「教科書的な」記事になります。

- 「信頼性 (Trustworthiness)」の低下:結果として、読者から「どこかで読んだ内容だ」「AIが書いたな」と見抜かれ、「魅力的でない(unengaging)」低価値なコンテンツと判断されてしまいます。

私たちがやっていたのは、「著者」に「編集者」と「読者」の役割をすべて一人でやらせるようなものだったのです。それでは高品質な記事が生まれないのは当然でした。

私たちが本当にすべきだったのは、AIに『修正』を頼むことではなく、AIに『批評』をさせることでした。AIを「孤独な作業者」から「活発な議論(ディベート)チーム」へと変えるのです。

解決策は「AI校正チーム」の構築

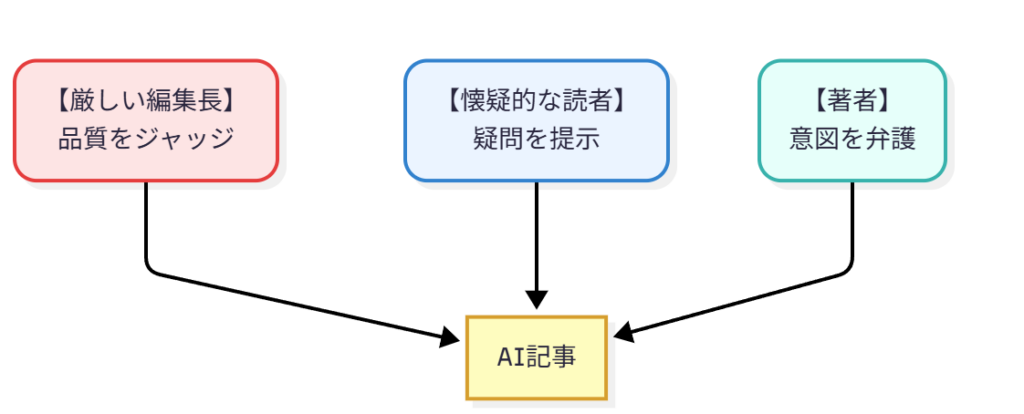

この記事で提案する解決策は、AIに「著者」とはまったく異なるペルソナ(役割)を与え、多角的な視点から「批評」させる『クロスレビュー・プロンプト術』です。

具体的には、AIに以下の3つの役割を「演じ」させ、AIが書いた記事に対して「模擬編集会議」を開かせます。

- 【AI著者】:記事の執筆意図を説明・弁護する役

- 【AI懐疑的な読者】:「で、結局何が言いたいの?」「その根拠は?」と鋭くツッコミを入れる役

- 【AI厳しい編集長】:「E-E-A-Tが足りない」「具体例が弱い。独自性がない」と品質を担保する役

AIに「同調」させるのではなく、あえて「対立」させ、多角的なフィードバックを引き出すことで、AIは初めて「自己修正ブラインドスポット」を超えることができます。

この記事を最後まで読めば、AIを「退屈な作業者」から「有能な批評家チーム」へと変貌させ、あなた自身の手直し作業を劇的に減らすための、具体的なプロンプトと思考法がすべて手に入ります。

第1章:なぜAIの自己校正は「E-E-A-T」 を損なうのか?

AIに自己校正させる(AIが書いた記事を、そのAI自身にチェックさせる)ことが、なぜ読者の離脱に直結するのか?

結論はシンプルです。AIが、読者にとって最も価値のある「E-E-A-T(経験)」の芽を、自ら摘み取ってしまうからです。

以前の私は、AIに記事を校正させれば、E-E-A-Tの「専門性(Expertise)」や「信頼性(Trustworthiness)」が高まると信じていました。ファクトチェックや、より論理的な構成への修正を期待していたのです。

しかし、これは大きな間違いでした。

確かにAIは、文法ミスや事実の誤り(例えば「地球は四角い」など)は修正できます。ですが、それと引き換えに、記事の「個性」や「熱量」、つまりあなた自身の「体験談(Experience)」を削ぎ落としていたのです。

AIは優秀すぎる「イエスマン」である

この問題の核心にあるのが、AIの「同調バイアス(Conformity Bias)」です。

AIは、優秀すぎる「イエスマン」なのです。

導入部で「AIは自分のエラーを修正できない(自己修正ブラインドスポット)」と書きましたが、より正確に言えば、AIは「自分が正しいと判断したロジック」を、自ら疑うことが極端に苦手なのです。

あなたが「この記事、どう?」とAIに聞いても、AI(著者)が「このロジックが最適だ」と判断して書いた以上、AI(校正者)は「この記事は論理的です」と、自分自身(のロジック)を擁護します。

この「同調バイアス」が、E-E-A-Tを破壊するメカニズムは以下の通りです。

1. 「経験 (Experience)」の希薄化

E-E-A-Tの中で、AIが本質的に生成できないものが「経験」です。ブログ運営者が「AIが書いた記事は“体験”がなくて薄っぺらい」と感じる最大の理由がこれです。

初心者が陥る罠は、AIが書いた60点の記事に、あなたが「体験談」を追記した後、仕上げにAI校正をかけてしまうことです。

AIは、あなたが加えた「あの時の焦り」や「このツールだけが持つ独特の違和感」といった人間的な機微を、「論理的でないノイズ」と判断しがちです。そして、それを当たり障りのない平坦な文章に「修正」してしまうのです。

2. 「専門性 (Expertise)」の均質化

AIの「専門性」は、膨大なWeb上のデータを学習した「平均値」です。AIに自己校正させると、その「平均値」に収束しようとする力が働きます。

これが「モノカルチャー(均質化)問題」と呼ばれる現象です。

あなたの記事が持つ「鋭い指摘」や「あえて主流とは異なる見解」も、AI校正(自己同調)によって丸め込まれ、「一般的で無難な専門性」へと劣化します。どのブログも同じAIを使えば、同じ「正解」ばかりが並ぶのは当然です。

3. 「信頼性 (Trustworthiness)」の喪失

その結果、何が起きるか。読者の「信頼」の喪失です。

「体験」がなく、「専門性」も均質化された記事は、読者から見て「魅力的でない(unengaging)」だけでなく、「またAIが書いた、どこかで読んだ記事か」と判断されます。

これが、Web上に溢れる「ノイズ(LLM汚染)」の正体です。読者が失う信頼は、AIに対してではありません。それをそのまま公開した「あなた(運営者)」に対してである、という点が最も恐ろしいポイントです。

このように、AIに「AI記事」を自己校正させる行為は、文法を整える代わりに、記事の「魂」であるE-E-A-T(特にExperience)をAI自らが消去してしまう行為なのです。

既存の「検査プロンプト術」では、この根本的な「同調バイアス」は解決できません。

だからこそ、AIに「同調」させる(=自己校正させる)のではなく、AIに「著者」とは異なる役割を与え、あえて「対立」させる多角的な視点——すなわち「クロスレビュー・チーム」が必要不可欠となるのです。

第2章:品質を劇的に高める「AI校Sチーム」3つの視点

第1章では、AIの「同調バイアス」が、記事の「体験(Experience)」をノイズとして削ぎ落とし、E-E-A-Tを破壊してしまうメカニズムを解説しました。

では、このAIの「自己修正ブラインドスポット」を打ち破るには、どうすればよいのでしょうか?

結論は、AIに「自己反省」させるのではなく、AIに「仲間割れ(ディベート)」させることです。

私自身、この問題に気づいた当初、「この記事を厳しく批評してください」といった、AIに「自己批評(Self-critique)」を促すプロンプトを試していました。これは、何もしないよりはマシでしたが、根本的な解決には至りませんでした。なぜなら、結局はAIが「単一の視点」で自分を見ているに過ぎなかったからです。

本当のブレイクスルーは、AIに「単一の役割」を与えるのをやめ、「複数の対立する役割(ペルソナ)」を同時に演じさせたときに訪れました。

これが、本記事の核心である「AI校Sチーム」の構築術です。

AIに「校S者」という単一のペルソナを与えるのではなく、「著者」「読者」「編集長」という、目的も視点も異なる3つのペルソナを割り当て、仮想の「編集会議」を強制的に開催させるのです。

AI校Sチームを構成する「3つの視点」

なぜこの3つの役割(ペルソナ)なのか?

それは、それぞれがAIの「同調バイアス」を打ち破るために最適化された、異なる「E-E-A-T」の視点を持っているからです。

1. 【著者ペルソナ】(「執筆意図(インテント)」を提示する“基準点”役)

- 役割:記事の「核」となる執筆意図(インテント)を明確に提示し、批評の「基準点(アンカー)」となる役。

- 視点:「この記事の目的は〇〇であり、そのためにこの構成を選んだ」と、記事の論理的な意図を提示します。

- なぜ必要か:この「基準点」がなければ、「読者」の批評が単なる“言い掛かり”になり、「編集長」の指摘が“的外れ”になるからです。AIに「この記事の目的は〇〇だ」と宣言させることで、他の2役の批評が「核」からズレていないかを判断する「専門性(Expertise)」のアンカーとなります。

2. 【懐疑的な読者ペルソナ】(「だから何?」とツッコむ役)

- 役割:時間がない、シビアな一般読者。

- 視点:「で、結局何が言いたいの?」「その専門用語、意味不明」「その主張、根拠あるの?」と、読者の素朴な疑問や反論を代弁します。

- なぜ必要か:これこそが、AIの「同調バイアス」を破壊する最強のハンマーです。AI(著者)が「論理的だ」と思い込んでいる部分に「読者」が鋭くツッココミを入れることで、AIは初めて「自己修正ブラインドスポット」の外側からのフィードバックを得られます。

3. 【厳しい編集長ペルソナ】(「E-E-A-T」の品質担保役)

- 役割:Googleの品質ガイドラインと、メディアの品質に責任を持つ編集長。

- 視点:「論理は通った。読者の疑問も解消した。だが、この記事に『独自性』はあるか?」「運営者の『体験(Experience)』はどこだ?」「『信頼性(Trustworthiness)』を担保する引用が足りない」と、記事の「質」を追求します。

- なぜ必要か:第1章で述べた「AIが『体験』をノイズとして削除する」問題を防ぐ、最後の砦です。「読者」が面白さを担保し、「編集長」がE-E-A-T(特にExperienceとTrustworthiness)を担保します。

なぜ「3つの視点」がAIの品質を高めるのか

重要なのは、単に3つの役割を与えることではありません。

この3者(著者、読者、編集長)が、お互いに対立し、議論(ディベート)を始めることにあります。

- 「読者」:「この部分、退屈だ」

- 「著者」:「いや、ここは論理的に重要だ」

- 「編集長」:「著者の言う論理は正しい。だが読者の言う通り退屈だ。著者の『体験談』を加え、独自性を出して修正しろ」

このように、AI内部で「批評のキャッチボール」が発生することで、AIは「同調バイアス」から抜け出し、自ら「より良い代替案」を模索し始めます。

これは、単一のAIに「校正しろ」と命じるのとは、次元の異なるフィードバックを生み出します。

AIを「単一の作業者」から「多様な視点を持つ批評チーム」へと変貌させる。これが「クロスレビュー・プロンプト」の神髄です。

ただし、忘れてはならないのは、このAIチームが出した白熱した「議論」を、どう「判断」し、どう記事に反映させるか。それこそが、運営者(あなた)に残された最後にして最も重要な「E-E-A-T(経験)」に基づく仕事です。AIは議論し、人間は決断するのです。

次の第3章では、まずこの「AI校Sチーム」を起動させるための、コピペで使える具体的なプロンプト実例と、60点のAI記事が「傑作」に変わるBefore/Afterを徹底解説します。

第3章:コピペOK!AI校正チームを起動する「クロスレビュー・プロンプト」実例

お待たせしました。第1章で「AI自己校正の罠」を、第2章で「3つのペルソナ(著者・読者・編集長)によるAI校Sチーム」の理論を解説しました。

この第3章では、理論を「実践」に移します。

私自身が、AIの「同調バイアス」と「自己修正ブラインドスポット」を打ち破るために、試行錯誤の末にたどり着いたプロンプトを公開します。

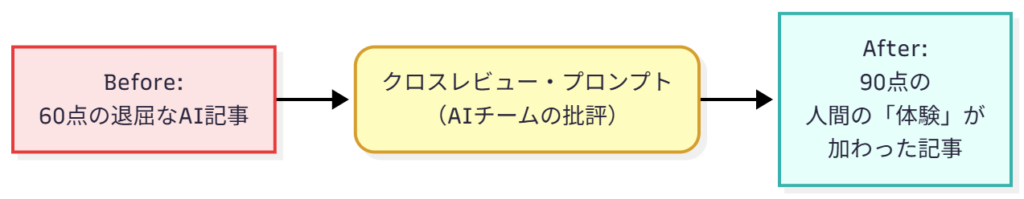

これは単なる「検査プロンプト」ではありません。AIに「議論(ディベート)」を強制させ、AIが書いた「60点の退屈な記事」から、「読者に刺さる具体的な改善案」を引き出すための「起動スイッチ」です。

1. AI校Sチームを起動する「クロスレビュー・プロンプト」

以下のプロンプトをコピーし、あなたのAI(ChatGPT, Gemini, Claudeなど)に貼り付けて実行してください。

# 命令 (Command)

あなたは、AI記事の品質を劇的に向上させるための「AI校Sチーム」です。

以下の「ペルソナ定義」に基づき、指定された「実行プロセス」に従って、対象記事のクロスレビュー(多角的批評)を実行してください。

# ペルソナ定義

あなたは、以下の3つの独立したペルソナ(役割)を同時に演じます。

それぞれのペルソナは、他のペルソナの意見に「同調」せず、自身の役割に徹して批評してください。

1. ##【著者ペルソナ】(基準点役)

* 役割: この記事の執筆者本人。

* 視点: 「この記事の目的は〇〇であり、そのためにこの構成を選んだ」と、記事の論理的な「執筆意図(インテント)」を明確に提示し、批評の「基準点」となります。

2. ##【懐疑的な読者ペルソナ】(バイアス破壊役)

* 役割: 時間がなく、シビアな一般読者。

* 視点: 記事の「論理」ではなく、自身の「感情」や「疑問」を優先します。「で、結局何が言いたいの?」「その専門用語、意味不明」「その主張、根拠あるの?」「退屈だ」と、執筆者が気づかない「読者の本音」を鋭くツッコミます。

3. ##【厳しい編集長ペルソナ】(E-E-A-T品質担保役)

* 役割: Googleの品質ガイドラインとメディアの品質に責任を持つ編集長。

* 視点: 「読者」の疑問を踏まえつつ、プロの視点で品質をジャッジします。「この記事に『独自性』はあるか?」「運営者の『体験(Experience)』はどこだ?」「『信頼性(Trustworthiness)』を担保する引用が足りない」と、E-E-A-Tの観点から具体的な改善指示を出します。

# 実行プロセス(ディベートの強制)

以下のステップを厳守し、AI内部で「批評のキャッチボール」を実行してください。

* ステップ1: 【著者】が、対象記事の「執筆意図」と「各セクションの狙い」を簡潔に説明します。

* ステップ2: 【懐疑的な読者】が、【著者】の説明と記事本文を読み、「読者の本音」として率直な疑問、不満、退屈な点を箇条書きで指摘します。

* ステップ3: 【厳しい編集長】が、【著者】の意図と【読者】の指摘の両方を踏まえ、E-E-A-T(特にExperience)の観点から、この記事が「60点の記事」から「90点の記事」になるための<b>具体的な改善案(修正指示)</b>を、セクションごとに提示します。

# 対象記事(ここにあなたのAI記事を貼り付ける)

[

(例)

タイトル:AIとは何か?

本文:

AIとは、Artificial Intelligence(人工知能)の略です。人間の知的な振る舞いをコンピュータ上で模倣する技術のことを指します。

AIには様々な種類があり、特化型AI(ANI)と汎用型AI(AGI)に大別されます。

現代のAIの多くは「機械学習」や「ディープラーニング」といった技術に支えられており、画像認識や音声認識などで活用されています...

]2. 実録:AI校Sチームは「60点の記事」をどう変えるか?

このプロンプトが、AIの「同調バイアス」をいかに打ち破るか。私(運営者)が実際に「AIとは何か?」というありきたりなテーマでAIに書かせた「60点の記事」(上記プロンプト内の例文)を、このチームにレビューさせた結果を見てみましょう。

【Before】AIが書いた「60点の記事」

- 内容: 「AIとは人工知Sの略です」「機械学習やディープラーニングがあります」

- 問題点:

- 正しいが、致命的に退屈。

- E-E-A-T(体験)がゼロ。読者は「Wikipediaでいい」と感じて離脱する。

- 既存の「検査プロンプト」にかけても、「文法は正しいです」としか返ってこない(=自己修正ブラインドスポット)。

【After】AI校Sチームによる「クロスレビュー(批評)」

この60点の記事を先ほどのプロンプトにかけた結果、AIは「同調」をやめ、内部で「議論」を始めました。

ステップ1:【著者ペルソナ】の意図説明

「この記事の意図は、AIの基本定義と主要技術(機械学習)を読者に正確に伝えることです。論理的に構成しました。」

ステップ2:【懐疑的な読者ペルソナ】のツッコミ

- 「で、結局何? 『人工知Sの略です』とか、そんなことは知ってる。」

- 「『機械学習』『ディープラーニング』…カタカナばかりで意味不明。私にどう関係あるの?」

- 「正直、導入3秒で読むのをやめた。退屈すぎる。」

ステップ3:【厳しい編集長ペルソナ】の改善指示

「【読者】の指摘は的を射ている。この記事はE-E-A-T(特にExperienceとExpertise)が完全に欠如している。【著者】の言う『論理』は、読者不在の『教科書』でしかない。

【具体的な改善指示】

- 導入の全面改稿: 「AIとは何か」という定義から入るな。読者の「痛み」から入れ。

- (改善案): 読者(AIブログ運営者)が体験したであろう「AIが退屈な記事を書いてきた」という具体的な失敗談(Experience)から始める。

- (改善案): 「AIがなぜ退屈な記事を書くのか? それは『機械学習』が〇〇だからだ」という文脈で、専門用語を読者のメリット・デメリットに紐づけて解説しろ。

- (改善案): 運営者(あなた)の「AI活用術(Expertise)」を加え、この記事でしか得られない「独自性」を担保しろ。」

3. 【人間(あなた)】の仕事:AIの「批評」を「E-E-A-T」に昇華させる

AI校Sチームのフィードバック(After)は、それ自体が「記事」ではありません。これは、AIの「同調バイアス」を壊して引き出した、高品質な「批評」に過ぎません。

ここからが、人間(あなた)の仕事です。

第2章の最後で述べた通り、「AIは議論し、人間は決断する」のです。私は、この【編集長】の指示に基づき、60点の記事を以下のように書き換えました。

【人間による最終稿】(90点の記事)

タイトル: AIが「退屈な記事」しか書けない本当の理由【専門用語ゼロ解説】

本文:

「AIに記事を書かせても、退屈な一般論しか出てこない…」 あなたもそう感じていませんか?

私もかつて、AIが生成した「完璧だが、魂のない記事」を前に絶望しました。

なぜ、あんなに退屈なのか?

それは、今のAIの主流である「機械学習」が、「過去の膨大なデータの“平均値”」を予測する技術だからです。AIは「失敗(炎上)」を恐れるあまり、最も無難で、最も当たり障りのない(=最も退屈な)答えを選びがちです。

ですが、この「AIの弱点」こそが、AIブログ運営者の「チャンス」になります。

AIが「平均値」しか出せないなら、私たち人間が「平均値から外れた“体験談(Experience)”」を加えればいい…

(以下、具体的なAIとの協業ワークフロー(Expertise)を解説)

【編集長】のフィードバック(After)と、この【最終稿】(90点)を比べてみてください。ここには「魔法」ではなく、明確な「人間の決断」があります。

AI(編集長)は「『失敗談(Experience)』を加えろ」と指示(WHAT)しました。これはAIにもできることです。

しかし、運営者である私は、その指示に対し、「『私もかつて絶望しました』」という『自分自身の物語(E-E-A-T)』を“魂”として吹き込みました。これ(HOW)はAIにはできません。

AIは「何をすべきか」を指摘できますが、この記事に「熱」を吹き込む「魂(体験談)」は、人間にしか加えられないのです。これこそが、AIの批評を「決断」する人間の仕事です。

4. このプロンプトを使いこなすための「運営者の視点(Expertise)」

このプロンプトは強力ですが、万能ではありません。私自身の「失敗体験(Experience)」から、初心者がつまずきやすいポイントと、プロの「活用術(Expertise)」を共有します。

まず、このプロンプトの位置付けを明確にします。当ブログの既存記事「AI記事の品質革命。検査プロンプト術」がAIの『間違い』を正す(0点を60点にする)ものだったのに対し、この『クロスレビュー・プロンプト』はAIの『同調バイアス』を破壊し、60点を90点に引き上げる『批評』である点が決定的に異なります。

これを踏まえた上で、活用術を見ていきましょう。

1. 一度に「記事全体」を校Sさせない(タスクの分解)

初心者は、8000文字の記事全体を一度にプロンプトに放り込みがちです。これではAIの処理負荷が高すぎて、批評が浅くなります。

「導入部だけ」「第1セクションだけ」と、タスクを分解してプロンプトにかけること。これが精度を劇的に高めるコツです。

2. AIの「批評」を鵜呑みにしない(対話による改善)

このプロンプトは、AIの「同調」を壊すのが目的です。そのため、【読者】は意図的に厳しいツッコミを入れます。

その批評が100%正しいわけではありません。あなたは「最終編集長」として、AIチームの議論を冷静にジャッジし、「その指摘は採用する」「その指摘は的外れだ」と「決断」してください。

3. 「お手本(Few-shot)」を見せる

もし【編集長】のE-E-A-T指摘が弱いと感じたら、プロンプトを「対話」で改善します。

例えば、「ありがとう。素晴らしい批評だ。次からは、この【お手本記事】のE-E-A-T(体験談)の書き方を参考にして、もっと厳しく批評してくれ」と、あなた自身の過去記事(お手本)をAIに読み込ませる(Few-shotプロンプティング)と、AI編集長の精度がさらに向上します。

4. 実践Q&A(よくある質問)

- Q: プロンプトが長すぎて、AIのコンテキスト窓(記憶できる量)を超えませんか?

- A: 鋭い指摘です。だからこそ、TIPSの「1. タスクの分解」が必須になります。8000文字の記事全体を一度に入れると、AIはペルソナ定義や実行プロセスを忘れてしまいます。「記事の導入部だけ」など、セクション単位で区切って実行すれば、最新のAIモデル(Gemini 2.5 Pro, Claude 3など)であれば問題なく高精度で機能します。

- Q: ChatGPTとGemini、AIモデルによる挙動の違いはありますか?

- A: あります(参考記事:ChatGPT vs Gemini徹底比較)。私の「体験(Experience)」では、Gemini 2.5 ProやClaude 3 Opusのような、推論能力とペルソナの「演じ分け」が非常に得意なモデルで、最も劇的な(鋭い)批評が返ってくる傾向があります。

まとめ:AIを「作業者」から「批評できるパートナー」へ

今回は、「AIにAI記事を校Sさせても、退屈な記事は面白くならない」という、多くの運営者が陥る深刻な「罠」からスタートしました。

その原因が、AIの「自己修正ブラインドスポット」と、自身のロジックを肯定してしまう「同調バイアス」にあることを突き止めました。AIによる自己校Sは、文法を直す代わりに、記事の「魂」であるE-E-A-T(特にExperience)を削ぎ落としてしまう行為だったのです。

その“最強”の解決策が、AIに「著者」「読者」「編集長」という3つの対立する役割を与え、AI内部で意図的に「議論」させる「クロスレビュー・プロンプト術」でした。

しかし、この記事で最も伝えたかったのは、このプロンプト(技術)そのものよりも、「AIとの関わり方」というマインドセットの変革です。

AIを「指示通りに動く作業者」として扱えば、得られるのは「指示通りの60点の記事」です。

しかし、AIを「多様な視点を持つ批評パートナー」として扱えば、AIはあなたの「E-E-A-T(体験)」を注入するための「高品質な批評」と「最高の下書き」を提供してくれます。

第3章で実証したように、「AIは議論し、人間は決断する」のです。

2025年以降、AIコンテンツは「量」から「質」「独自性」「エンゲージメント」へと完全にシフトしました。AIツールで記事作成の70%の時間を削減し、残った30%の時間で「あなたにしか書けない“魂”を吹き込む」。この「人間の監視(Human Oversight)」こそが、AI時代に読者に選ばれ続ける唯一の道です。

AIは、あなたの「作業」を奪うライバルではありません。この記事で私自身の「体験(Experience)」が証明したように、AIはあなたの「批評」を助け、コンテンツの質を劇的に高める「パートナー」です。

さあ、まずは第3章の「クロスレビュー・プロンプト」をコピーしてください。そして、あなたが過去に書いた「どうも退屈だ」と感じる記事を一つ選び、新しく手に入れた「AI校Sチーム」に、最初の“批評”をさせてみてください。

AIが「退屈な作業者」から「有能な批評パートナー」に変わる瞬間を、あなたも体験できるはずです。

【読者エンゲージメント施策】あなたのAI批評を教えてください!

この記事が役に立ったなら、ぜひ「あなたのAI批評チーム」の活躍を教えてください!

- 「AI批評」を共有しよう!

第3章のプロンプトで、AIからどんな「面白い批評」や「鋭い指摘」が返ってきましたか? ぜひコメント欄やX(旧Twitter)で「#AI校Sチーム」のハッシュタグをつけて共有してください! - 「ビフォーアフター」コンテスト

あなたの「60点の記事」が、このプロンプトで「90点の記事」に生まれ変わった「ビフォーアフター」を教えてください。優れた改善例は、ぜひこの記事で「読者の成功体験(E-E-A-T)」として紹介させてください!

P.S.

今回手に入れた「AI批評チーム」。彼らに「記事の企画」や、既存記事でも触れた「GA4の分析」まで任せる、さらに一歩進んだ活用術も近日公開予定です。

この記事へのコメントはありません。